Les prévisions de transport

Prévoir

L’exercice de prévision de transport répond, pour un objet (Pays, territoire, axe), à un objectif précis : prévoir, à un ou des horizons donnés, l’évolution de grandeurs que l’on considère comme stratégique ou d’intérêt ( pour le fret :Tonnes déplacées, véhicules, tonnes.km, véhicules.km, etc..).

Sur le plan méthodologique on distingue généralement ce qu’on appelle les démarches de prévision, de celle de la simple projection (modèles dits auto-régressifs), et de la prospective, mais aussi des modèles de simulation dont l’objet est plus cognitif ou exploratoire que centré strictement sur la prévision (tout en permettant d’ailleurs de prévoir).

Pour faire simple, la prospective serait plutôt l’art de décrire des scénarios possibles, avec une vocation descriptive, exploratoire, ou plus stratégique ou normative. La projection restitue l’évolutions « spontanée » d’une grandeur, la simulation tente de reproduire le fonctionnement d’un système complexe.

La démarche de prévision sera déterminée ou influencée par plusieurs facteurs :

- L’objet et l’objectif même de la prévision (plus ou moins large, plus ou moins précis, détaillé, etc..), il s’agit donc d’une demande plus ou moins explicite.

- L’état des outils utilisables (dont l’évolution a été considérable depuis la guerre)

- L’état (nombre, qualité, pertinence) des «données numériques» disponibles, dont la quantité et le détail varient dans le temps, qu’il s’agisse des grandeurs rétrospectives à prévoir, ou des variables dites d’entrée ou « explicatives ».

- Les méthodes choisies – qui sont toujours discutables – et dépendent de la démarche empruntée (on peut avoir une volonté plus ou moins cognitive).

Il en découle, dans le temps, des différences majeures, entre les prévisions réalisées.

Ainsi, avant 1954 en France, on ne dispose pas de mesure statistique macroéconomique globale des transports routiers en tonnes.km, mais une simple estimation. Par ailleurs certaines séries statistiques - le transport routier national, ou international – peuvent avoir des champs variables ou des contours différents dans le temps, et les enquêtes changer de logique. Le détail des données (types de marchandises, origines et destinations, .. ) peut-être variable et s’il a augmenté dans un premier temps, a pu régresser par la suite (Rail, Route, International ..).

En conséquence, les premiers modèles de prévision étaient relativement frustres et simplistes.

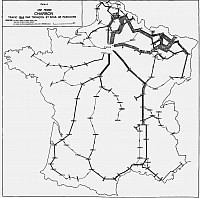

Pour autant, dans les années 1960, dans le cadre principal des travaux du Plan, la prédominance ferroviaire, la prépondérance des produits de base pondéreux, et la trop lente progression des statistiques routières, mode par ailleurs contingenté, a conduit à construire des prévisions fondées sur une approche sectorielle quasi monographique. Ainsi, la démarche choisie par le SAEI en 1962, se limitait tout d’abord au rail et à la voie d’eau, pour les produits de base, dans une perspective de court terme (3 ans) sur les axes principaux de transport. Les auteurs constatent en effet que les résultats des prévisions peuvent différer de manière sensible selon les axes.

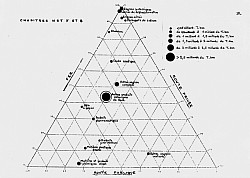

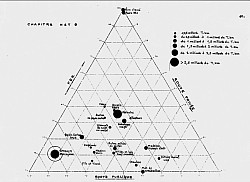

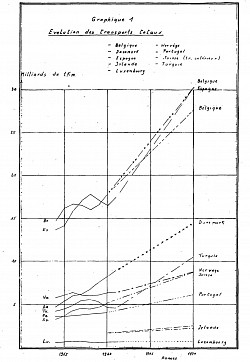

En 1964, on dispose de prévisions globales – compilées par la Conférence Européenne des Ministres des Transports (CEMT, organisme de coopération internationale) - à l’horizon de 1970 pou 15 pays d’Europe. Les modèles utilisés, au contraire de la démarche initiée peu avant par le SAEI, se contentent de relier les prévisions du PNB (Produit National Brut, usité alors), et des transports. Les pays se distinguent alors par les différences d’élasticités des tonnes.km au PNB, et le poids du rail.

La première version de Pretram (1978, SAE/SAEI, Ministère des Transports, France) relie simplement des données annuelles macroéconomiques en volume, à des tonnes.km par mode et par chapitre de la Nomenclature des Statistiques de Transport (NST). (voir présentation au colloque de Royaumont)

Une version ultérieure (1980-81), s’attachera à relier des transports par année, par mode et par NST à des indicateurs en quantités physiques, représentatifs de la spécialisation des modes de transport. Le même travail sera réalisé sur des données mensuelles, permettant des prévisions à court terme et à moyen terme plus précises. On a à cette époque (1980) combiné des modèles ARIMA (Autoregressive Integrated Moving Average) avec des modèles économétriques classiques pour améliorer les prévisions à très court terme.

L’une des difficultés majeures de construction et surtout d’utilisation de modèles numériques économétriques tient à la pauvreté des systèmes d’information. Bien que ces derniers soient potentiellement de plus en plus riches, il reste qu’ils ne répondent pas toujours aux besoins, et peuvent être d’un niveau de qualité, de rigueur et d’organisation non satisfaisants.

Mais la disposition de données prévisionnelles peut constituer une faiblesse encore plus sensible, mettant en cause l’usage même des modèles. Ainsi, par exemple, les prévisions en masses physiques ou en volumes physiques, n’existent que rarement (essentiellement pour les industries lourdes et l’agriculture).

Prévoir : les difficultés de modélisation et la « justesse » des modèles

La principale critique de ces modèles était qu’ils ne reflétaient pas la « doxa » de la modélisation selon laquelle la prévision devait découler d’un processus logique (supposé refléter un processus de décision) à trois (et idéalement quatre) étapes.

- La première étape consiste à générer une demande spécifiée (produits). Ces modèles prennent généralement en compte les potentialités d’émission ou caractéristiques économiques par zone.

- la seconde étape consiste à spatialiser cette génération (Origines, destinations), entre régions de destination également décrites par des données caractéristiques des zones de réception et la distance entre chaque zone.

- la troisième consiste étape consiste à répartir les flux entre modes, généralement en fonction de caractéristiques capacitaires, qualitatives et de prix.

- Enfin, la quatrième étape consiste à affecter les flux O-D à des réseaux (plus court chemin, utilité..).

Cette méthode se heurte à des difficultés méthodologiques (boucles de rétroactions entre étapes), statistiques, et pratiques.

Les travaux récents, permis par les progrès des moyens de calcul permettent de disposer de prévisions géolocalisées précises. Voir par exemple le rapport sur MODEM.

Mais il convient de noter que tous ces modèles (pas ou peu rétrocatifs) se heurtent à la disponibilités de données spécifiques (quantités, prix..), et adaptées à la détermination de valeurs en tonnes.km ou en tonnes à partir de données qui ne sont que partiellement en quantités physiques.

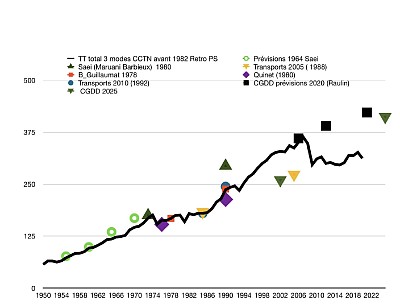

La prévision et la réalité

Confronter la prévision aux réalités (donc a posteriori), conduit naturellement à s’interroger sur les « facteurs » d’erreur. Grossièrement il s’agit de faire la part des choses entre les hypothèses (souvent erronées), la logique interne du modèle s’il est complexe, et les relations quantitatives entre variables d’entrée et résultats. Enfin, il est fréquent que les prévisions publiées soient différentes des stricts résultats des modèles. Il peut aussi exister des ruptures dans les séries étudiées, rendant difficile des comparaisons rigoureuses.

Il faut donc logiquement différencier les erreurs liées à la structure même du modèle – ce qui correspond par exemple à une modification structurelle de l’économie (dématérialisation, crise, mondialisation…) – des erreurs sur les prévisions prises comme variables d’entrée.

Ainsi les prévisions du début des années 1980, ou du début des années 2000, passent à côté du fléchissement de la croissance essentiellement en raison des hypothèses de croissance, mais aussi en raison de l’obsolescence du modèle utilisé. Historiquement on peut observer généralement que les prévisions anticipent rarement des ruptures, mais prolongent par construction des relations stables. Selon la spécification des modèles la prise en compte de la « dématérialisation de l’économie » peut être plus ou moins négligée. En outre les variations de prix, et singulièrement des prix des matières premières et les modifications structurelles de l’économie peuvent être sous estimées. En second lieu les hypothèses prises en compte reflètent plus la conjoncture récente, qu’une prospective raisonnée. Les prévisions sont donc très datées. La nature même des modèles économétriques explique cette forte inertie.

En troisième lieu, les prévisions ont tendance à surestimer certaines hypothèses ou leur influence. Ainsi, le transport ferroviaire est-il régulièrement presque toujours surestimé.

Aux facteurs évoqués s’ajoutent alors le caractère souvent « téléologique » des prévisions, comme ce peut-être le cas quand elles servent de support aux politiques publiques. Les évolutions sont supposées découler de mesurer fortes qui, en pratique, ne seront pas ou peu mises en œuvre, ou alors sont inefficaces ou illusoires. (voir Grenelle de l’environnement..)

Historiquement on peut observer généralement que les prévisions anticipent rarement des ruptures, mais prolongent par construction des relations stables. Selon la spécification des modèles la prise en compte de la « dématérialisation de l’économie » peut être plus ou moins négligée. En outre les variations de prix, et singulièrement des prix des matières premières et les modifications structurelles de l’économie peuvent être sous estimées. En second lieu les hypothèses prises en compte reflètent plus la conjoncture récente, qu’une prospective raisonnée. Les prévisions sont donc très datées. La nature même des modèles économétriques explique cette forte inertie.

En troisième lieu, les prévisions ont tendance à surestimer certaines hypothèses ou leur influence. Ainsi, le transport ferroviaire est-il régulièrement presque toujours surestimé.

Quand nous faisions des prévisions

Patrice (PS), ton arrivée dans le monde de la prévision ?

P.S. Les hasards de la vie professionnelle. La fin prévisible de l’opération RCB m’a poussé à chercher à passer aux études économiques. Or il y avait alors (fin des années 1970) une demande sociale évidente de prévisions à travers les travaux du Plan, et je présentais aussi des interrogations sur l’évolution des comptes des entreprises publiques et des concours publics (subventions). Or pour prévoir il faut des modèles qu’il fallait donc construire ou rénover. J’avais plus une culture de la planification stratégique, de l’analyse des systèmes et de l’évaluation économique que de l’économétrie. Et ma formation en dynamique des systèmes, en l’absence d’outils sur la marché, ne me permettait pas de l’utiliser comme je l’ai fait 20 ans plus tard.

Et toi, Christian (CR) ?

C.R. À mon retour en France en France des États Unis, en 1974, j’ai eu l’opportunité d’être embauché au SAEI, pour apporter une expertise en matière de modélisation de transport de voyageurs inter régionaux ( Équipe TRIP). Cela me permettait de combiner une formation en Mathématiques Statistiques et en Sciences Politiques/Économiques acquise à Paris puis New-York. A l’époque je n’avais qu’une vague connaissance des Transports, si ce n’est une petite connaissance de travaux conduits sur le corridor SE des USA. La réflexion était particulièrement intéressante à un moment où la décision sur le TGV Sud Est allait être prise. Puis je me suis orienté assez vite sur le transport de marchandises et les trafics internationaux avec une première évaluation de projet sur le QPO de Dunkerque (Quai a Pondéreux Ouest) et la mise au point d’un modèle TRIMAR, basé sur le même type d’approche que PRETRAM mais appliqué au transport international.

Sur quoi avez-vous travaillé et comment ?

P.S. En ce qui concerne les modèles d’entreprises j’ai participé (1978) à la réalisation des modèles sur différentes entreprises (RATP, Air France..) mais surtout sur la SNCF. Les enjeux financiers étaient majeurs, et notre approche était inexistante ailleurs au Ministère. Le problème de la reconstitution de comptes cohérents (je rappelle qu’on est passés de comptes TTC à des comptes hors-taxes), sur une période suffisante (1959-1977) fût assez pesant en raison de l’instabilité des règles comptables. La méthodologie me paraissait évidente. Considérer chaque poste comme un produit « Prix*Quantité » affecté d’un coefficient reflétant la productivité (ou un effet de structure) semblait naturel. C’est sur la base de modèles de ce type qu’on a pu tester des quantités d’hypothèses de trafic et de financement, et discuter des gains de productivité par poste. Dans les années 1983-84, ces travaux, en éclairant l’avenir à 10 ou 15 ans sous un jour un peu cru, n’ont pas plu à tout le monde. Mais il faut signaler ici que l’acquisition de nos premier micro-ordinateurs nous a permis de vivement progresser. Nous avons même développé (G. Malamoud) nos propres logiciels d’économétrie, puis de modélisation ARIMA etc..

Pour les modèles de prévision des transports , nous avons travaillé d’emblée sur le fret – sujet que je connaissais bien – laissant le transport de voyageurs à d’autres collègues (voir Pretrap, TRIP, etc..). Notre problème était assez simple. Les modèles existants ne marchaient plus. Les raisons étaient simples. On reliait alors des données explicatives en Francs constants à l’activité en t.km. Or il y avait une double distorsion volume/valeur. La première tient au fait que le PIB devenait de moins en moins tiré de l’activité de branches produisant des biens (tertiairisation), et que l’activité minière et de l’industrie lourde diminuait en valeur relative puis absolue. La seconde distorsion tenait au fait que les produits manufacturés devenaient de moins en moins pondéreux. Le nouveau « Pretram » pris donc le parti de relier essentiellement des tonnes.km à des productions physiques ou des indicateurs de production plus pointus, plus représentatifs des flux. D’où l’attention renouvelée portée aux filières productives ou à l’organisation logistique. Ensuite, la question sera de mieux intégrer l’international, et des collègues développèrent le modèle TRIMAR centré sur le transport international. La construction européenne et la mondialisation ont affecté massivement la structure des échanges. Ce fût un défi pour les prévisionnistes comme devrait l’être l’innovation (ce qui est rare).

C.R. Par la suite, j’ai continué à travailler (et enseigné) sur les différents techniques d’évaluation, et encadré des travaux sur le transport de grandes filières économiques (Sidérurgie, Aliments du bétail..), contribué à l’expertise de l’évaluation de grands projets et réalisé des expertises au Mexique sur les perspectives des grands ports et d’une manière plus générale sur l’estimation des flux et l’aménagement du territoire pour le Ministère du Budget et de la planification (SPP).

Puis j’ai changé de fonction pour prendre la direction du SAEP (Service d’Analyse Économique et de Planification du Ministère) pour diriger des travaux plus généraux de projections de transport notamment dans le cadre du 9 ieme plan dans lequel des projections économétriques de marchandises étaient combinées avec des visions plus qualitatives de professionnels. C’est à cette période que avec l’impulsion de Patrice SALINI au cabinet, il a été possible de créer un organisme original, l’Observatoire Économique et Statistique des Transports, responsables des statistiques, de la planification et de l’évaluation des projets et politiques de transport, donc un organisme dont une production essentielle était celle de prévisions et projections pour l’ensemble des transports de marchandises.

Quelle fut la suite ?

P.S. Je n’ai pas fait ça très longtemps, en raison de mes changements successifs d’activité. Mais revenant aux études et à la recherche bien plus tard, j’ai continué à construire des modèles en fonction des besoins de mes études, et j’ai exploré – dans le cadre de projets financés par le PREDIT ce que pouvait nous apporter la dynamique des systèmes avec des modèles comme Simtrans (transport national de marchandises), Simpactrans (Transport et politique commune agricole), Simtrans CO2 (intégration d’un module CO2 et de quota d’émission), Axefret (simulation d’un axe dédié de transport combiné), etc… Ah ! j’oubliais, j’ai toujours enseigné à côté de mon activité principale, dans diverses universités (Paris XII, Paris IX Dauphine, Paris 1, Paris IV, etc..), et même participé à la création d’un Institut universitaire professionnalisé transports-logistique (Institut Management Transport Logistique Lieusaint, IMTL), où j’avais réussi à implanter un enseignement de Dynamique des Systèmes (confié à Michel Karsky, puis Valérie Gacogne). Et à Dauphine, j’avais créé une Unité de valeur consacrée aux transports et à la dynamique des systèmes au tournant des années 2000 en MST Méthodes de la Prévision et de la Modélisation. Par la suite, j’aurais voulu parvenir – sans réussir – à intégrer les ressources de la simulation dynamique dans les processus d’évaluation des politiques publiques.

C.R. La suite a d’abord été celle de l’OEST avec ses succès et ses difficultés face à des directions sectorielles au sein du Ministère, histoire que Patrice a bien partagé en défendant son indépendance au Cabinet, puis en en prenant la direction lorsque je suis retourné à la recherche, à la direction du DEST, département d’économie et de sociologie du transport de l’INRETS (Etablissement Public de Recherche en Transports), en succédant à Roger Marche, un spécialiste reconnu de la modélisation, avec lequel j’avais déjà beaucoup appris. Une de mes mission était d’ouvrir plus largement le département aux recherches européennes (travail déjà engagé par mon prédécesseur), à un moment où le 4ème PCRD (programme Européen) prenait de l’ampleur. Cela m’a amené à conduire des projets européens importants sur la définition de scénario, l’introduction d’analyses de qualité (Intermodal Quality), le développement d’un réseau Européen (Eufranet) à priorité fret, le développement de réseaux en Méditerranée (Meda Ten T) et de participer à de nombreux autres projets de prospective et d’ouverture à l’Est.

Enfin avec plusieurs chercheurs nous avons créé une société d’application de la recherche (NESTEAR), en lien avec l’INRETS dans le cadre de la loi innovation de 1999.

Cette société a continué à être impliquée dans les programmes européens de recherche en mettant au point un outil d’évaluation et de projections de transport, et réalisé plusieurs projets de recherche dans le cadre du PREDIT ((MODEM sur la modélisation marchandises, INTERALP sur les politiques transalpines, TEAM pour l’accessibilité fret, autant d’activités qui contribuent à affiner les outils d’analyse et projection. En France ces outils ont aussi été utilisé pour l’évaluation de grands projets en France (GPSO, LNMP, CFA…) ainsi que pour des projets portuaires et Autoroutes Maritimes.

Quelles leçons ?

P.S. On peut, je crois, en tirer plusieurs.

- La première est que la demande sociale est déterminante. Si elle n’existe pas ou est faible, il est difficile de construire une inter-relation utile entre producteurs et utilisateurs de modèles et de prévisions.

- La seconde est que toute prévision est par nature fausse.. mais on ne peut décider sans anticiper, donc sans prévoir, sans savoir dans quelle mesure on se trompe. D’autant que les hypothèses macroéconomiques ou sectorielles ne nous « appartiennent » pas. En outre il y a forcément des contradicteurs. Je l’ai connu avec les acteurs du secteur. La SNCF avait ses propres prévisions, et chacun pouvait bien entendu ne pas « croire » en nos prévisions. Prévoir c’est accepter de débattre. Ce qui est bien. Mais j’aurais eu envie qu’on discute des méthodes aussi.. et pas seulement de la qualité des tests de nos modèles, qui, avouons-le, à la fin des années 1970, nous utilisions peu, notre « œil » jouant alors un grand rôle. Cette remarque vaut d’autant plus que les modèles sont complexes.

- La troisième est que certaines méthodes sont considérées comme « orthodoxes » chez nous, et que le recours par exemple à la dynamique des systèmes est au mieux incompris, au pire combattu de manière vive (cf réunions du Predit). Il reste que le choix d’un outil ne signifie nullement qu’on l’utilise correctement. On pourrait en parler plus longuement.

C.R. Elles sont nombreuses et sont d’abord une confirmation de celles de Patrice,

A celles-ci j’ajouterai des remarques spécifiques plus directement liées aux projets que j’ai connus, et qui leur donnent aussi un autre éclairage. Elles ont été aussi fortement marquées par un travail de recherche européen Européen (EVATREN) sur des analyses ex-post de travaux d’évaluation de projets Européens.

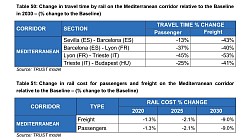

Dans une période où la croissance générale des trafics tend à se ralentir et où les concurrences entre modes, techniques, itinéraires sont plus vives, il est bien clair que des hypothèses d’évolution de coûts et de performance deviennent essentielles. En effets les évolutions seront d’abord celles de transferts entre solutions de transport.

Or ces hypothèses dont rarement formulées de manière suffisamment explicite ou précise, lorsqu’elles ne sont pas biaisées par un tropisme modal trop fort. Leur nombre et l’absence de statistiques disponibles ne permettent pas des ajustements statistiques satisfaisants, explicitant rigoureusement les effets d’hypothèses testées. Les outils économétriques classiques ou progiciels qui les abritent deviennent des boîtes noires donnant l’illusion que la multitude d’hypothèses impliquées sont prises en compte.

Et pourtant à l’opposé on voit se développer des bases de données d’offre géo-codées de plus en plus riches décrivant les réseaux, les liens et noeuds voire des horaires. L’idée est donc d’utiliser au mieux ces nouvelles données sur des « performances de réseaux pour simuler des situations de concurrence qui vont jouer « point à point », donnant tout son sens aux combinaisons modales et intégration de maillons. Devant une telle accumulation de données, l’algorithme doit être souvent privilégié par rapport l’ajustement économétrique qui perd toute signification. Une véritable interrelation doit être établie entre la performance du réseau et le processus de choix d’une solution, alors que bien souvent l’affectation sur réseaux, tout en étant plus précise, fait illusion car elle n’est en réalité que l’illustration d’un choix de solution déjà acquis.

Un dernier enseignement est bien que l’évolution des techniques de modélisation sont souvent plus lentes que ne le laissent croire les sorties de modèles; les difficultés pour sortir un modèle Européen « officiel » depuis plus de 10 ans (Trimode après Transtools… 3) pour donner un outil commun d’évaluation en Europe, en témoigne. Comme en témoigne la difficulté de sortir d’une problématique de recherche sur la modélisation établie il y a plus de 10 ans…

ASTRA, le modèle européen dominant

Les modèles en Europe

Le processus de modélisation

Au niveau de l’Europe, l’histoire des modèles de transport utilisés est une longue histoire qui a évolué dans le cadre de recherches du PCRD (Programmes-cadre pour la recherche et le développement technologique) au milieu des années 90, pour se concentrer plus aujourd’hui sur le développement des Réseaux Trans Européens (RTE), et en particulier sur la planification de corridors prioritaires jusqu’à l’horizon 2030, puis sur celle du Réseau Européen de transports à l’horizon 2050.

L’approche avait toujours pour vocation affichée d’être multimodale, et est progressivement devenue très liée aux objectifs de politique poursuivis, avec ainsi le développement de différents modèles suivant que l’initiative relevait plus d’une direction en charge du développement des RTE, ou bien d’unités sectorielles plus directement attachées au transport ferroviaire ou bien à celui du transport maritime et de la voie d’eau. Cela étant le développement des RTE est devenu dominant, les autres unités jouant alors un rôle plus complémentaire dans la modélisation.

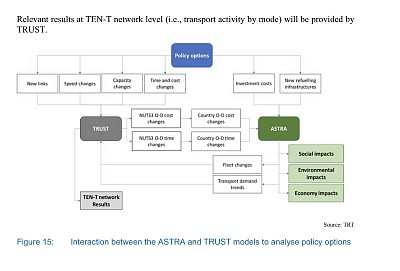

Pour évaluer le développement des RTE, ce contexte a alors conduit à mettre l’accent sur le fait que le PIB est trop souvent pris comme une variable exogène dans les modèles de transport, alors que le développement d’une politique de transport (en l’occurrence celle du développement des RTE de par les investissements en infrastructure et de ceux qui améliorent l’exploitation) doit être considéré de manière endogène permettant d’évaluer son impact sur la croissance supplémentaire de PIB Européen généré de ce fait, sur la croissance des emplois, et sur les effets sur l’environnement. D’où la constitution d’une ASP (Astra System Dynamic Model Platform), gravitant autour du modèle ASTRA, (un modèle de Dynamique des systèmes de M-FIVE, décrit plus loin) pour préciser notamment les impacts sur l’environnement et les transports (modèle TRUST de TRT), voire se mettre en cohérence avec d’autres systèmes de données, comme la base TEN tec, pour la description géocodée des liens et nœuds, ainsi que de plusieurs milliers de projets participant au développement des RTE.

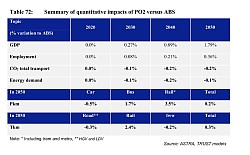

Ainsi l’utilisation de cet outil permet d’estimer, avec les investissements prévus pour les RTE de 2016 à 2030 (rapport Impact of TEN-T completion on Growth, Jobs and Environment 2018), une croissance supplémentaire de PIB Européen de 1,6%, une augmentation de près de 800.000 emplois, une réduction des émissions de CO2 de 26 ML de T (liés aux investissements du réseau noyau en 2030, constitué essentiellement par les corridors prioritaires), et ce pour un investissement estimé à plus de 550 Millards €, avec donc un effet multiplicateur global de 3,3 sur le PIB.

Ce développement permet une augmentation de 4,7% du fret ferroviaire, un léger recul de la route de -0,4%, et une faible augmentation de la voie navigable de 0,4%. Les parts modales sont ainsi assez peu affectées pour le fret comme d’ailleurs pour les voyageurs. A noter toutefois que la baisse de CO2 attendue est beaucoup plus importante, de 71 ML de T, lorsque l’on prend en compte la réduction d’émission liée au développement de technologies de véhicules propres.

L’analyse des mesures d’impacts est alors déclinée par corridor et par pays en fonction des types d’investissements réalisés et des trafics concernés. La composante maritime et portuaire de l’impact de cette politique est quant à elle apportée par un modèle d’une autre nature (modèle Nestear de BG présenté dans le rapport Assessment of potential of maritime and inland ports, and inland waterways, qui sera présenté par ailleurs 2020).

A noter qu’en 2021 une nouvelle analyse d’impact a été réalisée avec cette platforme ASP prenant en considération des variantes plus volontaristes (Policies options) entrainant un impact environnemental et un effet multiplicateur supérieur (….).

On peut alors déduire de tout ce travail d’évaluation d’une politique que l’accent a bien été mis sur le modèle de génération et ce qu’il peut apporter au niveau Européen, mais aussi à un niveau éventuellement agrégé, par pays, mode, corridor, type d’investissement (pour voyageurs et marchandises), pour monter l’impact global d’une politique et ses déclinaisons, créant ainsi toute une grille d’indicateurs d’impact qui va s’appliquer à la mise en œuvre du développement de RTE. Pour ce faire on peut notamment se référer aux différents « workplans » (Actuellement le 4 ième) de planification des corridors dont 4 traversent la France, et y intègrent la plupart des grands axes.

Les questions

Néanmoins ce type de modélisation n’est pas sans poser beaucoup de questions, non seulement au niveau de la validation d’un tel modèle de dynamique des systèmes (à noter au passage que des organismes Français de recherche ne participent pas ou très peu au développement d’ASTRA ou de l’ASP) mais aussi pour les prévisions de trafics, la mise en œuvre de solutions intermodales, et surtout la concurrence entre les modes, ce qui constitue quand même un aspect important. En effet le modèle TRUST se situe en aval et limite de fait à des problèmes d’affectation sur le réseau de volumes d’échanges éclatés entre barycentres de zones nuts 3 (équivalent département en France). Si l’on peut reconnaître, que les réseaux sont détaillés, géocodés, y compris des terminaux multimodaux et ports, et que l’affectation sur itinéraire, pour un mode, est aussi détaillée, le modèle ne prend pas en compte les données de compétition entre modes sur une relation donnée, et de manière assez grossière les conditions de transport terminal souvent déterminantes. Le fait de privilégier des mécaniques de génération a conduit en pratique à négliger la modélisation de l’exploitation des transports et de la concurrence entre solutions, modales et intermodales. De ce fait les interactions entre l’étape de l’affectation et le partage modal sont négligées (retour de l’effet réseau qui ne se limite pas à l’impact de la congestion sur le choix d’un itinéraire modal). Et en définitive le dispositif de modélisation sera assez peu sensible à l’émergence de nouvelles solutions modales ou intermodales.

Des interrogations fortes

En conclusion de ces réflexions sur les modèles au niveau Européen et national on ne peut que s’interroger :

- Au niveau Français sur le fait que des réflexions ne soit pas poursuivies sur la modélisation de la génération de trafic, ni sur celle de l’exploitation des transports, dans une approche harmonisée multimodale et intermodale (avec des hypothèses harmonisées notamment sur des coûts d’exploitation des différentes solutions de transports), laissant ainsi toute réflexion prospective très enfermée dans une approche modale.

- Au niveau Européen d’une prédominance d’un modèle de génération, qui malgré son intérêt, soulève lui-même des questions et qui, de fait, donne une évaluation du développement des RTE qui fait largement l’impasse sur l’évolution des mécanismes de choix des solutions de transport.

- Et enfin sur l’absence de relations entre les travaux réalisés en France et ceux réalisés sur la planification des corridors prioritaires, et des RTE, au niveau Européen (qu’ils s’agisse de modèles ou de résultats d’évaluation d’impact. Et pourtant il est bien clair que l’évaluation de projets majeurs en France passe par la mise en place d’un modèle de réseau européen, de par sa position centrale en Europe, aussi bien pour des déclinaisons par corridor que pour l’évaluation globale du projet, socioéconomique et environnementale. D’ailleurs à ce stade on peut rappeler que RFF dès 2001 demandait un modèle de réseau Européen pour le fret (Modèle Scénario Fret, développé par Nestear suite à la réalisation du projet EUFRANET du 4ème PCRD sur un réseau à priorité fret en Europe, auquel participait SNCF et DB), comme il a exigé un modèle de réseau Européen pour l’évaluation des projets GPSO et LNMP au début des années 2000. Il semble bien y avoir sur ce plan une recul, alors que l’on serait en droit d’attendre un progrès.

Voir aussi : European Commission, Directorate-General for Mobility and Transport, Assessment of potential of maritime and inland ports and inland waterways and of related policy measures, including industrial policy measures : final report : executive summary, Publications Office, 2020,

L’évolution des modèles… raison ou illusion ?

L’évolution des modèles de prévision ne résulte pas de la seule concurrence entre théories et méthodes, et leurs perfectionnement. Elle résulte largement de l’évolution des moyens de calcul et des données numérisées disponibles. Ceci conduit mécaniquement à une croissance de la taille des modèles qui ne résulte pas que des seules exigences des utilisateurs. Les premiers modèles macroéconomiques français (Zogol, Deca, FiFi, Star), voient leur nombre d’équation augmenter progressivement. Fifi regroupait environ 1000 équations, DMS presque le double… Si les premiers se contentaient de livrer des résultats à l’horizon de prévision, les plus récents décrivaient une évolution dynamique. Dans le même temps la conception théorique des modèles a pu évoluer. La technologie permet par exemple maintenant, plutôt que de travailler directement sur des agrégats, et des relations temporelles continues, d’opter sur un la prise en compte du comportement individuel dans de vastes modèles multi-agents. Il reste que ce recours qui est évidemment efficient par exemple pour simuler – et donc calibrer – les mouvements de foule dans et autour d’un stade ou d’une gare, est plus complexe dans le cas d’une grande économie, et pose un ensemble de questions théoriques que la technique ne peut masquer. De même les limites – au-delà de prévisions à très court terme – des modèles économétriques conduit naturellement à explorer d’autres voies, comme celle de la Dynamique des Systèmes. Ce que relève d’ailleurs explicitement W. Schade, créateur du modèle ASTRA, l’évolution du sytème de transport ne se manifestant qu’à long terme. Nous sommes dans les transports en présence de l’évidence de phénomènes non linéaires, d’interrelations complexes, de l’importance du rôle des variables d’accumulation (stocks…), du jeu des délais, phénomènes pourtant généraux dans l’économie. John Sterman (A Skeptic's Guide to Computer Models.. ), rappelle le caractère essentiel, central, de l’objet et de l’objectif de la modélisation. Cette évidence devrait nous conduire à revenir à l’essentiel et à la parcimonie.

Les gros modèles

Pratiquement les gros modèles requièrent un nombre croissant exponentiellement de variables, et donc de données numériques historiques, et une bonne estimation de variables qualitatives sans dimension. Or, mécaniquement, la dynamique des systèmes requiert un plus gros travail de recueil de données et de calage. (En effet, le passage de l’économétrie à la dynamique des systèmes reviendrait par analogie à remplacer des « phrases » compactes (signifiantes) par des mots, leurs règles grammaticales.) Ce qui conduit d’ailleurs comme dans ASTRA à coupler des approches mécanistes à des approches dynamiques pour en réduire la complexité. Ainsi Astra combine des relations économétriques (donc non analytiques et rarement bouclées), l’usage des matrices de Leontief (TEI carrés), et des blocs de dynamique des systèmes. Ca n’est donc pas un modèle de dynamique des systèmes stricto sensu.

Toujours est-il, si l’on en croit Michael Krail ( System-Based Analysis of Income Distribution, Impacts on Mobility Behaviour, November 2008) Astra, dans sa version utilisée pour les simulations sur la période 1990-2050 (27 pays de l’UE plus Norvège et Suisse), incorporerait 29 millions d’objets. Ce qui est plus que considérable. Est-ce réaliste ?

Calage, tests et mutations structurelles

L’un des problèmes principaux de ces « gros modèles », est bien entendu lié à leur taille, et donc aux difficultés de calage du modèle (qui se fait par simulations successives, et tests). Il ne s’agit pas ici en effet de se contenter de tester un bloc de simulation mécanique, mais de tester un modèle dynamique complexe, et donc chacune des relations élémentaires.. ici des milliers. Ce qui peut conduire, au bout du travail de modélisation, à reconsidérer la stratégie. La complexité légitime est-elle utile à l’objet du modèle ? Crée-t-elle plus de risques ? Sur les milliers de boucles de rétroactions identifiées, certaines sont-elles dominantes ?

Un autre problème est bien entendu posé. Il s’agit de la prise en compte – pour des simulations sur 50 ans environ – de modifications structurelles non endogènes (générées par le modèle), et d’innovations. A ce stade on sent bien que la solution n’est pas probabiliste, mais relève d’hypothèses exogènes ou de la prospective technologique (voir Samba) que l’on peut traduire en variables d’entrées dans le temps.

Il faut cependant avoir conscience que la taille des modèles – et parfois le caractère « secret » autour de leurs équations – alimente le sentiment de « boîte noire » souvent évoqué. Au surplus, le lien entre des décisions politiques (règles, investissements, fiscalité, etc..) et des résultats sur des dizaines d’années n’est plus présenté comme une simulation permettant la discussion – et la compréhension des mécanismes et leur approfondissements – mais comme produisant un résultat utile unique.

Retour sur ASTRA

(Sur ASTRA-EC, voir en particulier le rapport ASSIT)

On arrive alors, de notre point de vue, à utiliser les ressources de ce type de modélisation dans un sens dévoyé. Ainsi, dans le cas de l’usage d’Astra dans l’éclairage économique du programme d’investissements des réseaux transeuropéens de transports (1000 milliards € d’ici 2050), on finit par complètement laisser de côté le détail des hypothèses d’effet direct des infrastructures (évaluations), pour se concentrer sur la croissance du PIB et des emplois (in fine, le modèle ici est une énorme calculette transformant des millards en points de PIB et en emplois, voire en CO).

D’autres problèmes de calage demeurent posés et sensibles. Le passage tonnage-valeur des produits – à un niveau relativement agrégé des branches des TEI – n’est pas un problème simple, et ne peut être homogène ni stable dans le temps et l’espace.

Pour aller plus loin, la construction du modèle ne semble pas prendre en compte des boucles de rétroaction (feedbacks) essentiels à moyen ou long terme. Ainsi, on peut estimer que les investissements peuvent effectivement modifier l’offre comme la demande de produits. Ce qui modifie la la répartition spatiale de la valeur ajoutée et des échanges inter-branche, et probablement certains prix. Plus encore, l’innovation ou des mécanismes comme la transition économique changent considérablement dans le temps les coefficients techniques des matrices de Leontief utilisées. Ces coefficients sont basiquement utilisés dans les modèles d’équilibre économique calculé (Computational General Equilibrium (CGE)). Le fait que les transports soient le support (et un élément de coût, et donc de répartition) des échanges (Consommations Intermédiaires, demande finale, commerce extérieur..), justifie l’intérêt du recours à des Tableaux d’échange interbranches. Or le recours de matrices carrées de Leontief repose généralement sur des coefficients fixes impliquant donc des productivités constantes et la non substitution de produits dans le temps. En second lieu, comme le rappellent Francesco Andria et Davide Provenzano, les relations sont linéaires et les branches/produits demeurent à des niveaux de globalité faisant perdre aux coefficients leur signification. Et que dire des passages tonnes/Euros.

Altération de la trame causale ?

Ces problèmes altèrent naturellement la nature réellement « causale » de la trame du modèle, pour finalement se rallier à une présentation statistiquement mécaniste du système représenté. Ce qui pose un grave problème compte tenu des horizons de prévision retenus.

Le problème est donc ici triple :

- Le caractère non pluraliste des outils limite clairement le champ du débat. Il faudrait des concurrents à Astra.

- L’usage de la Dynamique des Systèmes devrait favoriser la réflexion sur les mécanismes et donc sur la nature des effets et leur propagation, et non ce qu’elle peine à faire compte tenu de l’utilisation actuelle d’ASTRA.

- Astra en tant que modèle hybride dont on ne connait pas le détail (non public) est difficile à analyser, et en particulier il est malheureusement pas possible d’avoir accès aux travaux de calage et de simulation, et de connaître le détail des boucles de rétroaction entre blocs du modèle.

Prospective Française 2040-2050

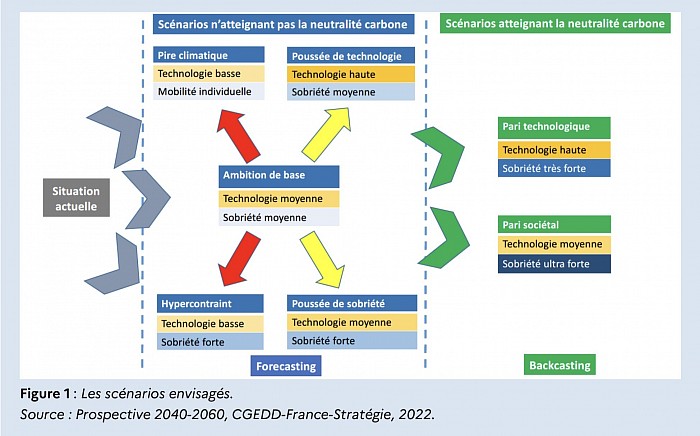

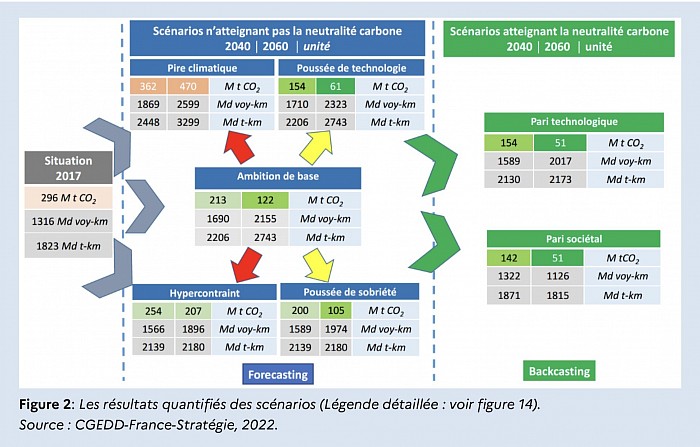

Le Conseil Général de l’environnement et au Développement Durable, et France Stratégie viennent de publier (Février 2022) une analyse prospective sur le thème de la mobilité à l’horizon de 2040/2060.

Avec une préoccupation simple : peut-on espérer atteindre les objectifs annoncés en matière d’émission de CO2.

Pour répondre à cette question il a été convenu de : « combiner backcasting et forecasting sur les mobilités à longue échéance 2040, 2060 avec un regard particulier sur 2030. »

Le groupe de travail et ses rapporteurs ont combiné en fait un certain nombre de tendances et de ruptures possibles (technologie, comportement) pour façonner des scénarios qu’on peut contraindre grâce à la réflexion de backcasting. Au final l’objectif étant bien de formuler des recommandations.

Des lacunes ?

La lecture de ce document – dans l’esprit assez éloigné de ce qui faisait le cœur des travaux de prospective il y a une cinquantaine d’années plus structurés sur le plan méthodologique, met en relief essentiellement l’importance des difficultés pour atteindre les objectifs assignés. Il prend en compte essentiellement les perspectives économiques – semble-t-il indépendantes de l’évolution des technologies et des comportements. Il n’intègre pas – ou alors très (trop) prudemment les modifications structurelles des modèles économiques productifs dans le domaine des transports. On a un peu l’impression que l’ensemble des moyens de transport changera peu, pas plus que l’organisation du système de transport, seule l’origine de l’énergie pouvant changer. De même les comportement sont essentiellement vus du point de vue des pratiques de mobilité (et donc de la demande) et bien peu du point de vue de l’offre et de l’organisation productive. Or, il semble bien que l’intérêt de la prospective est précisément d’imaginer des ruptures ou des scénarios impliquant des évolutions structurelles. Ainsi par exemple, la question des automatismes routiers (ou autres !) est considéré comme « incertaine » pour l’essentiel.

C’est donc de ce point de vue un document décevant intégrant pour fondamentalement les opinions dominantes actuelles, mais s’ouvrant peu, concrètement, sur l’évolution du secteur des transports. Un simple regard sur le passé montre que ces changements – parfois plus que les innovations technologiques, ou parallèlement à elles – ont façonné des transformations majeures, des ruptures considérables. Comment un travail prospectif peut-il négliger qu’en une quarantaine d’années nous avons transformé de manière majeure nos moyens de transport et de manutention, et développé une conception nouvelle de la logistique. Comment fait-elle pour ne pas imaginer que l’avenir ne nous réserve pas qu’un immobilisme mâtiné de transition écologique ? On cherche vainement les logiques à l’œuvre (tendances, contradictions, régulateurs, ruptures,..)

La question de fond est alors aussi de savoir à quoi sert un tel exercice de prospective, mobilisant une communauté importante, sans référence à un véritable mécanisme de planification, qui permette de garantir qu’un minimum de recommandations pourront être traduites en décision.

De plus comment mettre en avant un mécanisme de confrontation entre une démarche forcasting et backcasting (déjà tentée dans les recherches du PCRD, tel le projet Foresight) sans un minimum de cadre quantifié pour s’assurer qu’il existe des cheminements possibles, entre point d’origine et horizon projeté. Parmi les contraintes de type macroéconomique il y a au moins le constat que la France se trouve dans une situation extrêmement déficitaire sur le plan du commerce extérieur, et que cela a une incidence forte sur la géographie des flux de marchandises. On ne peut effeuiller un travail prospectif en thèmes comme une marguerite, sans se préoccuper qu’il existera encore une tige. Les exercices prospectifs conduits il y a 50 ans sous contrainte énergétique, et déséquilibres extérieurs l’ont bien montré, lorsqu’il s’agissait de transport et d’aménagement.

Prospective et planification…

Cela ramène aussi à un troisième point à savoir le déroulement parallèle d’un travail de planification en cours, au niveau Européen, non seulement sur les réseaux trans européens et l’exploitation mais aussi sur le fonctionnement de noeuds que constituent les principales villes. Cette planification se double d’objectifs environnementaux quantifiés à l’horizon 2050, auxquels s’adapte progressivement un dispositif réglementaire. Il y a là aussi un travail de cohérence à assurer, et un contexte prégnant pour la France qui est central dans tout travail prospectif et trop souvent absent.

Tout travail prospectif, si séduisant soit-il de par la mobilisation qu’il implique, comporte aussi le danger d’apporter une satisfaction qui ne peut se traduire en actes politiques.

A cet argument on peut apporter deux illustrations : le travail prospectif de 2005 où il y a eu un effort pour revenir sur les réflexions antérieures, et en tirer des leçons et fournir en projection un minimum de cadrage quantifié: un exercice de rigueur indispensable.

Quelles sont alors aujourd’hui, en préalable, les leçons des derniers travaux prospectifs du CGPC profondément marqués par la crise financière ?

Le cheminement au coeur des problèmes

Dans les programmes de recherche Européens la question de la prospective et de la vision à long terme a été centrale dès le milieu des années 90, pointant très vite deux principes :

- celui de l’importance de la définition d’un scénario de « référence » intégrant un minimum d’informations quantifiées, constituant une sorte de dénominateur commun ( projet Scénario),

- et de l’exploration des cheminements possibles ( « pathway » du projet Foresight) entre la situation présente et toute image projetée du futur

Cela permet de traduire cette question en terme de mise en œuvre d’une politique et donc en faire un acte de responsabilité face aux défis.

Il est vrai que dans Foresight, il était difficile de trouver un cheminement qui ne conduise pas à une Europe à plusieurs vitesses à un moment où l’intégration de nouveaux membres semblait résoudre tous les problèmes : cela n’en était que plus utile pour bien être conscients des défis à surmonter, et montrer l’importance des contraintes de cohérence dans tout exercice prospectif, qui ne peuvent être trop rapidement traités comme risques associés.

Ports et Réseaux européens

Mais pour en revenir aux questions plus particulières du transport, et en particulier de marchandises, par delà les questions de méthodes on peut faire aussi les remarques suivantes

- l’absence d’une véritable référence au travail de planification des Réseaux TransEuropéens(RTE), lequel intègre des questions d’exploitations, d’énergie alternatives, de gestion de points nodaux que sont les grandes villes: ce travail a débuté il y a près de 8 ans et s’affine continuellement

- avec en particulier le fait qu’il n’y aucune mention, dans le rapport sur les ports et le transport maritime (à l’exception d’hypothèses de croissance), d’un travail prospectif réalisé pour la Commission sur des scénarios portuaires et voie d’eau, dans le cadre de la planification des RTE (dont les étapes sont 2030 et 2050). Ce travail est pourtant l’un des rares réalisé récemment sur le sujet par la division en charge du secteur «waterborne» y compris sur les Autoroutes de la Mer. Ces scénarios définissent une référence et intègrent des bien entendu des données relatives aux technologies, accompagnés de projections de trafic intégrant la concurrence entre modes terrestres. Voir ici la révision du règlement sur les RTE

- et enfin un rapport pour le transport de marchandises qui reste très modal, se contentant souvent d’un plus grand dénominateur commun, avec une voie d’eau supposée renaissante (« SNE contribuant fortement sur la croissance des trafics attendus ») et un secteur ferroviaire, dynamisé en sortie de la crise de COVID, pour afficher des ambitions de doublement de part modale, sans oublier de nouvelles technologies routières qui en limiteront très significativement l’impact sur l’environnement. On voit bien ici comment la conjoncture influence le propos prospectif.

De l’utilité et de l’usage de la prospective

Une question est dès lors posée : Comment tous ces éléments peuvent se combiner et s’intégrer dans la perspective en cours de planification européenne ?

L’objet de ces remarques n’est pas de nier un travail réel et séduisant sur des perceptions d’avenir, associant un grand nombre d’experts, dont certains sont parfois très critiques, mais de pointer que derrière une apparente unanimité se cachent des problèmes politiques d’arbitrage masqués alors que la prospective doit aider à les résoudre. De ce point de vue le transport de marchandises dans ses composantes régionales ( à l’exclusion sans doute de la logistique urbaine plus spécifique), nationales, européennes et internationales est un bon exemple.

Sur la soutenabilité des « gros modèles »

Objectifs

Les modèles de prévision doivent concilier deux objectifs.

- Ils doivent répondre aux objectifs fixés. Autrement dit « rendre service », leur service : Prévoir à un horizon donné des indicateurs donnés. Explorer (ou pas) des trajectoires. Permettre de mesurer la sensibilité aux hypothèses (entrées, comportements..), etc.

- Découler d’une analyse et d’une conception théorique assurant la cohérence du modèle. Autrement dit il faut que les causalités soient justifiées..

Contraintes

Cependant, les modèles doivent « faire avec » des contraintes fortes :

- De disponibilité des observations nécessaires, au niveau de détail souhaité, et sur une période de temps » suffisante dans le passé.

- De détail suffisant pour construire des relations causales crédibles.

- De comptabilité des champs des données utilisées, par exemple entre les variables économiques de comptabilité nationale, les variables de production ou d’échange en volume, les variables de production ou d’échange en quantités physiques.

Ces contraintes sont additives et s’appliquent aussi bien aux quantités qu’aux prix.

Toute l’ambiguïté des modèles de transport réside d’ailleurs dans la conciliation des objectifs et la gestion des contraintes.

Or nous savons que la construction d’un modèle « global » doit faire l’impasse sur certaines contraintes qui ne peuvent être satisfaites.

Des objectifs difficiles à atteindre

S’agissant des objectifs, il est évident que la modélisation pour faire des prévisions à moyen ou long terme en créant une réelle difficulté théorique, en limite l’enjeu, tant il est évident qu’à un horizon de 10 ou 20 ans, les ordres de grandeur et les dynamiques l’emportent largement sur la précision, d’autant que les hypothèses jouent un rôle essentiel sur les résultats. C’est d’ailleurs pour cela que la « scénarisation » est nécessaire (savoir varier les hypothèses).

Il reste que lorsque ces modèles globaux tentent à la fois de livrer des résultats d’ensemble, mais aussi de les géolocaliser, et de les décliner par mode de transport et par type de marchandises ou d’usages du transport de voyageur, il démultiplie les facteurs d’erreur (encore que ce mot soit inadéquat). Au surplus la demande exige parfois à juste titre de disposer d’une image future, mais aussi d’un film prévisionnel décrivant une trajectoire.

Disons-le clairement, à l’horizon de 20 ans, disposer par couple origine-destination de flux (en tonnes) par type de produit (à quel niveau de détail ?), en lien avec les échanges interbranches et les productions et demandes finales par zone géographique, tenant compte de l’évolution des coûts de transport, de leur règlementation et des créations ou modifications d’infrastructures, relève d’un objectif dont on peut douter du réalisme. D’autant qu’on est bien en mal, de disposer d’une description réaliste de ces variables dans le passé, même récent.

Or, cette exigence, si on cherche à mener une analyse causale de la détermination des valeurs des variables en cause (qui sont déjà plusieurs milliers..), devra prendre en compte de multiples autres variables, à commencer celles qui reflètent les transformations techniques et l’innovation. De même, les relations numériques entre variables n’on aucune chance d’être fixes (coefficients constants) dans la durée.

Autrement dit, plus le niveau de complexité des sorties attendues du modèle augmente, plus le nombre de problèmes insolubles – ou de «blancs» dans les relations causales - et leur chiffrage augmente. D’où d’ailleurs des simplifications méthodologiques extrêmes, dévoyant parfois (souvent ?) le principe même du modèle.

Les questions que nous nous posons sur les grands modèles sont donc légitimes, et n’ont pas souvent de réponse claire, ou ne peuvent en avoir.

Le cas particulier de la dynamique des systèmes

D'ailleurs, l’intérêt de la dynamique des systèmes – à condition de ne pas la dévoyer- est précisément de s’abstraire d’une partie de ces contraintes, dans la mesure où l’ont s’intéresse plus aux mécanismes, aux processus, aux comportements, qu’à une prévision précise. Elle vise plus à comparer des stratégies qu’à livrer des oracles chiffrés. Le plus souvent, les modèles de dynamique des systèmes sont intéressant par ce qu’ils peuvent montrer des ruptures ou des crises, des limites à des processus continus. Mais leur insertion dans un ensemble hybride, avec un nombre faible de boucles de rétroaction, en supprime largement l’intérêt.

De manière plus fondamentale on demande souvent aux modèles transport de faire ce que les modèles économiques ne font pas, ou mal : une géolocalisation sectorielle. Alors posons-nous la question fondamentale de l’intérêt de passer par un tel niveau de détail ? Ou pour le dire autrement, la multiplication des niveaux de détail est-elle vraiment raisonnable ou soutenable ?

Bibliographie Dynamique des Systèmes

Modéliser les transports de fret… pas si simple

Modéliser les transports… pas si simple

Une expérience de la modélisation des transports : 1975-2020

Ce petit article traite de notre expérience de la modélisation. Par soucis de simplification nous nous concentrerons uniquement sur celle des transports et des trafics de marchandises. Des problématiques parfois identiques peuvent être rencontrées dans d’autres domaines (modélisation économique, mesure des effets macroéconomiques des politiques, etc..). Un sujet central tant la modélisation peut nourrir à la fois les réflexions sur la politique des transports et éclairer les décisions sur les projets d’infrastructure.

Les chemins qui mènent aux modèles

On arrive à la modélisation de différentes manières. On peut y être formé (ou déformé), on peut aussi y arriver de manière herméneutique, parce qu’on cherche à comprendre « ce qui se cache » derrière des données, ou un phénomène. La facilité ne pousse pas à l’analyse causale poussée, hélas, lorsque l’on dispose d’un outil qui permet de vérifier s’il y a un rapport quantifiable entre des données. On choisit ainsi une variable à expliquer, et on teste une ou plusieurs variables explicatives. En creux, on suppose qu’un phénomène économique – représenté par une série de données numériques - peut se réduire à une fonction d’une ou plusieurs autres variables numériques.

On butera donc logiquement sur des problèmes de qualité de l’ajustement opéré (d’où une myriade de transformations permettant de « linéariser » les relations, et d’éviter que les résidus aient une forme bizarre – signifiante -), et sur des problèmes de qualité et de pertinence des données elles-mêmes. Et bien sûr on devra s’interroger sur la pertinence des résultats.

Il est possible de donner le bel exemple d’un ajustement de très belle qualité qui en gros indiquait que moins on produit de betteraves, plus on en transporte. La relation mathématique trouvée n’avait bien entendu aucun sens, moins il y avait de sucreries, plus on transportait loin les betteraves, ce qui n’était pas sans rapport avec la baisse de la production.

Les travaux des années 1980

A la fin des années 1970, en transports de marchandises, nous nous posions une question fort simple : pourquoi les liens apparents entre le PIB et le niveau de transport s’étaient transformés ? Comment expliquer et prévoir ce qui se passait ? A cette question, on pouvait chercher à réponde en bricolant à l’infini les modèles (ah ! ces résidus !), ou en cherchant à comprendre. Nous nous sommes donc lancés dans une analyse quasi microscopique des transports, regardant dans le détail le contenu grossier des agrégats que nous utilisions (à l’époque une dizaine de regroupements de marchandises par nature, les chapitres de la NST d’alors). Et là, il fallait se rendre à l’évidence. Les « chapitres » de la NST n’étaient pas homogènes, et les modes de transport n’avaient pas la même spécialisation à l’intérieur de chaque chapitre. On décida donc de modéliser autrement…(Pretram 2, D. Chatard, C. Reynaud, P. Salini, SAE, 1980) de nous en remettre à des variables explicatives « physiques » et non plus « monétaires », à des échanges ou des productions, bref à la réalité de ce que l’on transporte. On comprit alors mieux, et on estima précisément les mécanismes qui avaient basculé dans les précédents modèles dans la poubelle des résidus souvent autocorrélés et incompréhensibles.

La même logique nous amena sur des séries longues ferroviaires (grâce à la compilation du Professeur Caron) à nous interroger sur la signification des résidus des fonctions de production que nous ajustions... puis de mettre en œuvre une méthode empirique de validation de cycles observés via les résidus, présentée dans un colloque en 1980-1981 (voir : P. Salini : « analyse économétrique des chemins de fer de 1828 à 1913 », in La demande de transports, Presse de l’ENPC, 1982). Cette méthode était, sans le savoir, celle initiée dans les années 1920 par N.D. Kondratieff (voir : N. D. Kondratieff, « les grands cycles de la conjoncture », Economica 1992)... mais sans ordinateurs !

Il s’agit là des mérites de l’économétrie que de permettre d’approfondir les questions qu’on se pose.. et plus rarement de jouer les oracles. Ceci dit, cette utilisation prédictive n’est pas sans intérêt. C’est même l’usage dominant des modèles économétriques que d’alimenter des prévisions. Or, à très court terme (jours, semaines, …), les vertus de modèles autorégressifs, intégrant plus ou moins des liens entre les aléas ont leur utilité propre, et, sur le plan cognitif, mettent l’accent sur la nécessité de comprendre pourquoi les phénomènes attendus ne se produisent pas. (voir G. Malamoud, P. Salini, «Modélisation à court terme du transport de marchandises par les méthodes de Box et Jenkins », Oest, 1980).

Mais la prévision et a fortiori lorsqu’elle porte sur des horizons éloignés pose à l’approche économétrique un autre type de problèmes. D’abord, se pose la question de la stabilité (reproductibilité) des relations (comportements) dans le temps, et ensuite, celle plus complexe encore de l’apprentissage et de l’innovation qui sont le propre de tout système économique (et humain). En prospective, on prend le soin de relever les tendances lourdes, et les facteurs de rupture qui affectent – dirigent – le comportement d’un système. C’est naturellement ce à quoi nous sommes confrontés lorsqu’il s’agit de se projeter à plus de 10 ou 15 ans. Mais il est utile de le faire… (voir par exemple : Perspectives Transports 2005, OEST, 1988).

Mais, il n’y a aucune raison de penser que les relations élémentaires mises en évidence par le calcul (économétrie) s’avèreront stables. Dans un modèle de type économétrique, les facteurs de changement ne peuvent être qu’exogènes, sauf à donner un poids énorme au hasard, donc quelque part aux résidus des estimations passées. Or, généralement, dans les modèles courants, les variables structurelles jouant à long terme (par exemple touchant à la productivité des systèmes de transport, à l’évolution des technologies, a fortiori à leur « révolution »), sont totalement négligées. D’où une faiblesse croissante d’autant plus importante que l’horizon de prévision est lointain. Mais pour le très court terme les prévisions s’avèrent tout autant fragiles. En effet, à court terme les faits de conjoncture ont un impact fort – que les économètres rangeront souvent au rang d’aléas – altérant l’exercice de prévision. Ainsi, par exemple, une grève – non prévisible, inattendue – un évènement météorologique, une crise financière même lointaine modifieront fondamentalement les données observées, et rendront les prévisions caduques. Or, des évènements extérieurs, peuvent durablement affecter les comportements (voir : R. Bergel, A. Friez, P. Salini : « La conjoncture de décembre 1986 et les grèves dans les transports », Notes de synthèse de l’OEST, février 1987) ;

La simulation

Ces perspectives n’interdisent nullement le travail économétrique, mais en fixent les limites. Ainsi, « La continuité supposée des mécanismes économiques passe par une machinerie complexe, non continue, physique, informationnelle, géographique, monétaire, dont les rythmes varient dans le temps et sont fondamentalement différents. Un mélange allant de la vitesse de la lumière et celle de l’âne dans les ruelles improbables d’une médina. On voit bien le caractère nécessairement réducteur d’une vision continue, simple, non médiatisée de l’économie. Offre et demande sont largement des abstractions dont la représentation sommaire se heurte à la réalité des processus, sans parler du jeu social et de ses forces. » (Patrice Salini : « Introduction à la dynamique des systèmes, L’Harmattan, 2017). Il faut donc s’essayer à autre chose. Ce que, depuis longtemps, il est possible de faire avec la « dynamique des systèmes ».

Dans les années 1970, si les logiciels n’étaient pas largement diffusés, les écrits de J. Forrester parvenaient jusqu’à nous (Jay Forrester, Industrial Dynamics (1961), Urban Dynamics (1969), World Dynamics (1971)), et le rapport Meadows (The Limits to Growth,Donella H. Meadows, Dennis L. Meadows, Jørgen Randers, William W. Behrens, 1971) offrait une exposition mondiale à l’approche de J. Forrester à travers le livre du club de Rome sur les limites de la croissance (Rapport sur les limites de la croissance, éditions Fayard, 1973). A vrai dire, on passa alors trop vite sur les travaux menés pour se concentrer sur les conclusions qui se résumèrent, hélas, au seul titre du livre de vulgarisation du club de Rome.

L’utilisation de l’approche systémique et singulièrement de la dynamique des systèmes, semblait donc utile pour prendre en compte spécifiquement la réalité du système de transport. Ce fût fait par exemple en ce qui nous concerne avec Simtrans (M. Karsky, P. Salini : « Prospective des transports de marchandises en France à l'horizon 2020. Une application de la dynamique des systèmes complexes : le modèle SIMTRANS. », 1999), puis d’autres modèles (SimtransCO2, Simpactrans, etc..). Au niveau Européen, l’application la plus connue est celle initiée à la fin des années 1990 par les frères Schade. W. Schade justifie parfaitement bien le recours à la méthode compte tenu de la grande inertie des systèmes de transports. Mais l’évolution de ce modèle, désormais intégré dans un ensemble plus complexe et d’inspiration diverse, (voir : https://pensertransports.simdif.com/les_prévisions_de_transport.html) l’a conduit à un niveau de complexité excessif, et surtout à ce qui semble une incohérence méthodologique. Ainsi, si l’on en croit Michael Krail, (System-Based Analysis of Income Distribution Impacts on Mobility Behaviour, November 2008, https://ideas.repec.org/p/lis/liswps/506.html), Astra, dans sa version utilisée pour les simulations sur la période 1990-2050 (27 pays de l’UE plus Norvège et Suisse), incorporerait 29 millions d’objets. Ce qui est plus que considérable et difficile à maîtriser.

L’intérêt de la dynamique des systèmes est double. En premier lieu la simulation est intéressante parce qu’elle décrit « comment » on passe finalement d’une situation de départ à une situation ultérieure. Le chemin est ici plus important que le résultat. Les logiciels de simulation (Stella, Vensim, Powersim…) permettant de visualiser l’évolution dans le temps (courbes, tableaux de bord, etc.) des variables de son choix. On découvre souvent des discontinuités, des cycles, des ruptures possibles. Ici, la compréhension des phénomènes, l’analyse des facteurs explicatifs devient centrale. De ce point de vue la simulation est formatrice ; elle contribue à la connaissance en raison même de la prise en compte d’inter-relations multiples dans le temps, ce que permet une modélisation mêlant des niveaux et des flux, et – fondamentalement - le temps et des délais, ainsi que des rétroactions (feedbacks).

Idéalement, ce qui est difficile à obtenir, est d’associer directement les commanditaires et surtout les « politiques » à l’utilisation d’un modèle dynamique, pour alimenter l’analyse commune, partager les interrogations et les réflexions. Malheureusement, les commanditaires recherchent rarement à partager une réflexion et des interrogations, mais attendent généralement UNE réponse. Ils veulent réduire leurs incertitudes, et non risquer de les augmenter !

La géographie et l’Europe

Ces méthodes pèchent toutes cependant par leur absence de prise en compte de la géographie physique et leur négligence relative à la problématique des réseaux (développement, management etc..). En effet, au-delà de quelques cas spécifiques, et limités géographiquement (simulations de terminaux intégrés dans un modèle de transport combiné dans Axefret par exemple {P. Salini, Predit, 2006}), nous sommes loin alors de la prise en compte des réseaux.

Pour l’évaluation des grands projets, ainsi que le développement des Réseaux Trans Européens (RTE), la prise en compte de la dimension géographique de l’espace Européen (et de ses ports) est devenue indispensable pour rester pertinent dans la modélisation du transport de marchandises.

Cela présupposait :

· La constitution de bases de données suffisamment homogènes pour les flux ainsi que sur la description géocodée des infrastructures y compris leurs noeuds « d’interchange » pour des solutions inter modales recherchées (programmes ETIS et TEN-TEC de l’UE).

· La définition d’un scénario de référence pour l’environnement socio-économique qui était repris des travaux de prospective de la DG Économie de Bruxelles et de ses déclinaisons au niveau de la DG Transports et Énergie (les noms ont changé à plusieurs reprises) qui fournissaient des données de projection par pays et produits : le but est d’obtenir un corpus d’hypothèses d’environnement socio-économique faisant l’objet d’un consensus aussi large que possible (projet SCÉNARIO du 4ème programme de recherche -PCRD-européen) ;

· La mise au point d’un modèle de transport, comprenant une génération de trafic partant d’un modèle économique spécifique, ou bien s’appuyant sur les outils mentionnés précédemment dont les résultats étaient distribués entre les régions (utilisation de la base RÉGIO Européenne) voire en leur sein.

La réalisation d’un modèle Européen a eu beaucoup de difficulté à aboutir, coordonnée depuis une dizaine d’année par TRT (Italie), s’efforçant de concilier différents démarches (Transports, Énergie…) pour aboutir à un « modèle de modèles », l’UE n’ayant toujours pas donné une référence sur les flux pour les réseaux Européens. A noter toutefois en France le développement du modèle LOGIS (Nestear) qui est le fruit d’une participation à ces projets Européens ainsi qu’à des travaux d’évaluation en France de grands projets qui ne pouvaient se concevoir sans la dimension Européenne. Il a produit des résultats d’affection à l’échelle de l’Europe pour tous les modes et leurs combinaisons possibles, montrant pour des grands projets l’importance de concurrence entre itinéraires, ce qui est rarement traité et difficile à faire admettre (voir : « Modélisation de l'intermodalité pour des politiques alpines environnementales. INTERALP », Nestear, Predit) et le rôle que peuvent jouer les solutions intermodales, y compris Autoroute de la Mer, considérées à cette échelle (notamment GPSO, LNMP, CFAL pour les projets ferroviaires, Saône-Rhin pour la voie navigable, Accès aux ports, Transports Combiné dans des projets Européens).

La modélisation multi-agent

Une approche particulière, qui nous rapproche des préoccupations relatives aux réseaux de transport et à leur management, peut être trouvée avec la modélisation multi-agent (voir : From System Dynamics and Discrete Event to Practical Agent Based Modeling: Reasons, Techniques, Tools Andrei Borshchev & Alexei Filippov, Anylogic). Il s’agit là de simuler le « comportement concret », individuel des « agents ». Nous avons appliqué cette approche à la modélisation d’une partie du réseau ferroviaire français sous des hypothèses de gestion dynamique (non-planification) des trains de fret (https://www.anylogic.fr/resources/case-studies/optimizing-french-railways/). L’intérêt de cette approche, est qu’elle est compatible avec une modélisation plus large reposant aussi bien sur de la dynamique des systèmes (de préférence), ou sur des modèles économétriques classiques. Les méthodes de génération des flux étant exogènes, le modèle gère alors leur affectation voire leur répartition. L’un des intérêts de ces modèles (sous Anylogic) est de permettre de visualiser sur un plan le mouvement réel des agents, ainsi que certaines images en 3D. On retrouve là l’un des aspects pédagogiques de la simulation qui permet de voir l’évolution dans le temps du système étudié.

Finalement, ce survol de nos expériences aboutit à un ensemble de remarques et de questions.

Modéliser c’est quoi ?

Typologie

Il y a au moins deux grandes familles de modèles.

Les modèles économétriques dont la vertu supposée est de quantifier des relations mathématiques existant entre des variables économiques et sociales, et les modèles de simulation, dont l’objectif est de simuler le fonctionnement supposé d’un système, l’objectif étant tout autant de comprendre et d’anticiper, et de figurer – dans le temps – son évolution.

La différence intrinsèque entre les deux approches, réside dans l’approche de la complexité. Les premiers la redoutent, et cherchent à la réduire. Les seconds la considèrent comme structurelle, et faisant système. La première ne peut exister sans données quantitatives, la seconde s’intéresse aux relations causales élémentaires entre éléments du système étudié.

L’économétrie complexifie l’outil mathématique pour résoudre et réduire l’incertitude, la seconde s’échine à simplifier les relations et à les multiplier.

L’économétrie tire des relations ajustées sur le passé des lois pour prévoir l’avenir, la simulation observe l’effet d’hypothèses ou d’évènements sur le système modélisé, et ouvre à de nouvelles questions (voir : All models are wrong: reflections on becoming a systems scientist, John D. Sterman, Jay Wright Forrester Prize Lecture, 2002).

L’approche de la modélisation dépend donc fondamentalement de la posture épistémologique et des questions posées (Pourquoi modélise-t-on ?). De ce point de vue, le succès de l’économétrie répond sans doute à deux injonctions : donner un résultat, et une représentation des sciences humaines posant comme stables les lois quantitatives estimées.

C’est le croisement des deux facteurs (approche scientifique et questionnements) qui sera déterminant dans les choix.

La simulation, en ce qu’elle s’intéresse aux processus, aux évolutions, offre une représentation du réel qui offre une part non négligeable au hasard (c’est pour cela qu’on doit multiplier les simulations), et intègre un grand nombre d’inter-relations se déroulant dans le temps (il existe des délais). Cette spécificité en crée la richesse (l’avenir est de ce point de vue « multiple »).

(…)

Modéliser… (suite)

La modélisation comme pratique

L’expérience montre qu’il y a un risque d’enfermement.

Le premier est celui du « bornage » excessif. Simplifier c’est se donner confiance et se passer de la connaissance, sous prétexte de défaut de données. C’est aussi une paresse. Il y a des effets de rente, des logiques d’entrée dans le « big data », et là chacun balance sur la table ses données où son absence de données favorisant des analyses hermétiques les unes aux autres.

Le second est celui de l’habitude, de la culture et des routines. On privilégie une approche formelle et abstraite que l’on pense maîtriser, et on passe à l’as l’analyse causale : trop de modélisateurs, ne connaissent pas le marché des transports et prétendent trouver des relations de causalité. Ainsi, on observe des passages non analysés, non justifiés (de valeurs ajoutées ou de productions en € aux tonnes), et une difficile introduction de la Géographie (souvent réduite à des distances et du temps).

Le troisième peut être la fuite en avant techniciste. On privilégie alors les techniques d’adoucissement des courbes avec des transformations de Box-Cox, où on travaille les résidus d’ajustements, sans s’interroger sur leur signification sur le marché. On « plonge » sur les données disponibles en faisant comme si les variables sont vraiment causales, et justificatives. On oublie par exemple les échanges extérieurs. On retient des agrégats économiques mais non pertinents. On néglige la mauvaise estimation statistique des trafics locaux. On néglige totalement et on n’analyse pas les ruptures des séries statistiques régulièrement réévaluées parfois massivement (Transport routier). La même fuite en avant se retrouve quand on veut construire des modèles « territoriaux », en modélisant des O/D, et des fonctions d’utilité par solution modale pour avoir un modèle de réseau …

Les résultats ne sont pas satisfaisants, … mais les commanditaires s’en contentent ou s’en accommodent. Tout d’abord il faut reconnaître que le commanditaire est rarement neutre par rapport aux résultats attendus et il pourra toujours choisir un prestataire susceptible de devenir un avocat de son projet. Cela ne signifie pas que tout débat scientifique est écarté, le recours à une expertise extérieure ouvrant la porte à de tels débats, rappelant des limites connues des modèles mais ne proposant pas d’autres solutions. Dans ces comités « ad hoc », des oppositions franches sont très rares, ce qui n’est pas toujours le cas avec des experts extérieurs (SNE, LTF, voir Patrice Salini, « L'ivresse des grands projets d'infrastructure », l’Harmattan, 2018).

Les problèmes rencontrés ne découlent pas uniquement du modèle utilisé, mais aussi des hypothèses sur les coûts d’exploitation des modes et de leurs solutions alternatives qui impactent fortement les résultats, quelque soit l’outil utilisé. Les hypothèses sont souvent « orientées » et très difficiles à retrouver (voir : projet européen EVATREN – Improved decision-aid methods and tools to support evaluation of investment for transport and energy networks in Europe, 2009-2010, sur l’évaluation Avant/Apres). On peut ainsi plus facilement découpler des résultats d’une expertise scientifique sur le modèle et donc franchir plus facilement l’étape d’expertise, les experts s’affranchissant trop vite des responsabilités sur ces hypothèses. Sur ce point il faut reconnaître que Réseau Ferré de France (RFF) avait fait un effort tout particulier d’harmonisation des coûts d’exploitation des modes.

Face à ces limites des modèles du transport de marchandises, les tendances ont alors été soit une tentation technisiste en compliquant en compliquant des équations économétriques qui ne fournissent pas véritablement de meilleurs résultats, soit la recherche de nouveaux outils intégrant plus largement l’approche systémique (cf plus haut sur la dynamique des systèmes) ou bien la dimension géographique, bénéficiant au passage de données géocodées qui ont fait beaucoup de progrès au cours des 20 dernières années (cf plus haut sur des modèles de réseaux pour mesurer l’accessibilité ou évaluer des projets de RTE).

Cela a été pendant 20 ans la question de LOGIS, qui a apporté une solution, avec beaucoup de géocodage et recours à RO pour recherche de solutions…Elle vaut ce qu’elle vaut mais intègre mieux géographie, économie et transport et a été opérationnelle (beaucoup cherchant surtout à ne pas la mettre en avant).)

Cette fuite en avant se retrouve aussi dans l’univers de la simulation avec la construction de modèles intégrés mêlant diverses techniques sous prétexte de perfectionnement. (Voir ASTRA).

Face à ce triple risque, il faut redevenir pragmatique.

En restant sous l’angle en quoi les modèles reflètent des questions que l’on se pose sur le fonctionnement du marché, et non pas en recherchant des relations et en compliquant des formulations dont on ne voit pas à quoi cela correspond, avec en plus la question de la qualité des données mal traitée …on modélise depuis longtemps, il y a certes des progrès dans les bases géocodées, mais on ne modélise pas un marché du transport (surtout marchandises car il y a plus d’inertie pour les voyageurs) sans une bonne connaissance de ce marché et de son fonctionnement…surtout que, en plus, on met en regard des unités différentes (Valeur Ajoutée et Tonnes ou Tonnes.Kilomètres).

A ce niveau il faut indéniablement accepter de mettre l’accent prioritaire sur la compréhension (analyse causale), privilégier la simulation dynamique et géographique, accepter le complexe, et privilégier la connaissance (modèle verbal) à une quantification complexe et discutable.

L’évolution des modèles en Europe

Ont-ils été validés ?

La question de la validation des modèles est centrale, mais constitue également un vrai sujet scientifique. Pour simplifier les économètres s’en remettent à la double exigence de la théorie sous-jacente, et du verdict des tests statistiques. Le modèle doit être théoriquement juste et statistiquement robuste, autrement dit, bien que robuste, il doit être interprêtable. Les dynamiciens des systèmes, ont une approche différente dans la mesure où la construction du modèle consiste à s’assurer que chaque équation reflète bien le comportement modélisé, qu’il soit « mesuré » ou non. Tester le modèle sous des hypothèses extrêmes est alors essentiel.

On peut faire l’hypothèse que les modélisateurs respectent ces exigences. Cependant c’est a posteriori qu’on pourra juger de leur validité : sont-ils capables de prendre en compte les évolutions constatées… ? L’erreur de prévision n’est pas essentielle de ce point de vue : la question est de savoir ce qui a failli : le modèle (sa structure, ses équations…), ou les hypothèses exogènes ? En pratique, si les modélisateurs savent généralement parfaitement ce qui est en cause, les utilisateurs, hélas n’en sont pas informés, ce qui produit une sorte de « halo » autour des erreurs de prévision.

En outre, on a bien trop tendance à s’intéresser plus aux prévisions tirées des modèles qu’à leur logique interne, et à ce qu’ils enseignent.

Les modèles sont devenus des produits sur un marché

Les modèles ne sont-ils pas devenus plus un produit sur un marché d’expertise, fragmenté lui-même, qu’un sujet de débat scientifique ?

Des modèles souvent pris en défaut